Sztuczna inteligencja w miejscu pracy – wsparcie operacyjne czy ryzyko prawne? Jak unikać naruszeń RODO i przepisów prawa pracy

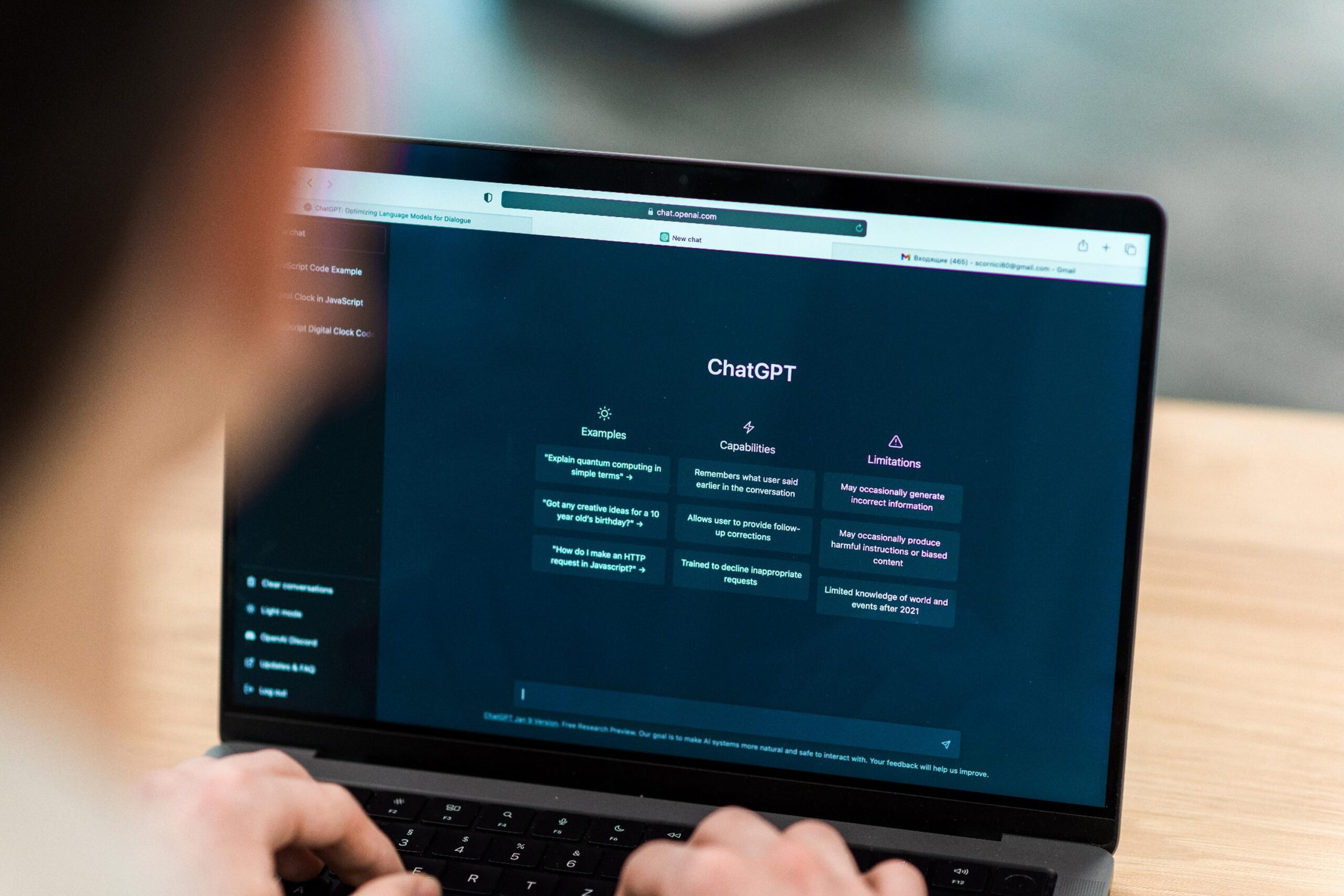

Sztuczna inteligencja jest dziś wszędzie – ChatGPT może nam podpowiedzieć co przygotować na obiad z resztek naszej lodówki, a Spotify dobierze playlistę na podstawie naszego gustu muzycznego. Usprawnienia, jakie oferują tego typu rozwiązania, w szczególności w zakresie szybkiej analizy danych czy generowania przydatnych dla nas treści, mogą nam znacząco pomóc również w naszej codziennej pracy – w tym zwiększyć naszą efektywność. Niemniej jednak, praktyczne zastosowanie AI w środowisku pracy rodzi szereg ryzyk prawne, w szczególności na gruncie przepisów o ochronie danych osobowych, przepisów Kodeksu pracy.

Naruszenia w związku z korzystaniem z AI

Pracownicy w celu ułatwienia swoich obowiązków mogą wprowadzać do narzędzi AI dane pochodzące z wewnętrznych dokumentów firmy. Jeśli jednak taki dokument zawiera dane osobowe, które nie zostały uprzednio poddane skutecznej anonimizacji lub pseudonimizacji, mamy do czynienia z przetwarzaniem danych osobowych z naruszeniem podstawowych zasad RODO a to przede wszystkim zasady legalności, minimalizacji danych oraz integralności i poufności.

Brak jednoznacznych procedur regulujących korzystanie z AI zwiększa prawdopodobieństwo naruszenia i może pociągać za sobą odpowiedzialność pracodawcy, obejmującą m.in. obowiązek zgłoszenia incydentu organowi nadzorczemu oraz osobom, których dane dotyczą, a także ryzyko sankcji finansowych.

Ponadto wprowadzenie niezweryfikowanych treści do zewnętrznego systemu AI może również prowadzić do nieuprawnionego ujawnienia tajemnicy przedsiębiorstwa – zarówno pracodawcy jak również jego kontrahentów.

Obowiązki pracownicze a wykorzystanie AI

W związku z wykorzystaniem narzędzi AI przez pracowników istotne znaczenie ma przepis art. 100 § 2 pkt 4 Kodeksu pracy, zgodnie z którym pracownik zobowiązany jest do zachowania w tajemnicy informacji, których ujawnienie mogłoby narazić pracodawcę na szkodę, a także do ochrony mienia pracodawcy. Wprowadzenie przez pracownika wewnętrznych dokumentów czy innych materiałów o charakterze poufnym do narzędzia AI bez odpowiedniego ich zabezpieczenia, może stanowić rażące naruszenie podstawowych obowiązków pracowniczych. Istotnym jest przy tym, aby zasady korzystania z narzędzi AI w firmie zostały uregulowane oraz jasno zakomunikowane pracownikom.

Jak ograniczyć ryzyko naruszeń?

Najskuteczniejszym sposobem ograniczenia ryzyk związanych z wykorzystywaniem narzędzi AI jest wprowadzenie jasnych zasad ich wykorzystywania. Pomocnym narzędziem może być przyjęcie kompleksowej polityki wewnętrznej (tzw. regulaminu korzystania z AI). Dokument ten powinien w szczególności precyzyjnie określać dopuszczalne sposoby używania aplikacji sztucznej inteligencji oraz procedury dopuszczalnego udostępniania informacji. Niezbędne jest wprowadzenie bezwzględnego obowiązku uprzedniej anonimizacji lub co najmniej pseudonimizacji wszelkich informacji zawierających dane osobowe.

Praktycznym narzędziem są również wewnętrzne szkolenia – dostosowane do specyfiki poszczególnych stanowisk i zagrożeń – które mogą przyjmować formę warsztatów obejmujących nie tylko omówienie obowiązujących przepisów (RODO, tajemnica przedsiębiorstwa), lecz także omówienia zasad bezpiecznego korzystania z narzędzi AI oraz procedur reagowania na incydenty naruszenia poufności. Regularne przeprowadzanie szkoleń zwiększa świadomość pracowników i w może w sposób jasny i przystępny przedstawić im obowiązujące zasady korzystania z AI.

Z pewnością sztuczna inteligencja może być niezwykle efektywnym narzędziem w miejscu pracy, pod warunkiem że jest wykorzystywana w sposób świadomy, zgodny z obowiązującymi przepisami oraz odpowiedzialny. Pozostawienie tej sfery bez jasnych regulacji wewnętrznych grozi nie tylko naruszeniem wymogów RODO czy zasad ochrony tajemnicy przedsiębiorstwa, lecz także poważnym ryzykiem reputacyjnym dla pracodawcy oraz konsekwencjami dyscyplinarnymi dla pracowników, którzy dopuszczą się naruszeń.

Jeżeli chcieliby Państwo uzyskać szczegółowe informacje lub wsparcie przy opracowaniu wewnętrznych regulacji dotyczących korzystania z narzędzi AI, zapraszamy do kontaktu. Nasz zespół może pomóc Państwu w przygotowaniu odpowiednich regulacji wewnętrznych, zgodnych z obowiązującym prawem, dostosowanych do specyfiki Państwa działalności oraz ukierunkowanych na ograniczenie związanych z tym zagrożeń, a także w opracowaniu i przeprowadzeniu dedykowanych szkoleń – w formie praktycznych warsztatów – z bezpiecznego i zgodnego z prawem korzystania z AI.

Joanna Czajor

Email: jczajor@kbzlegal.pl

Telefon: +48 32 202 42 97

LinkedIn

Latest Posts

KBZ | NEWSROOM – Certyfikacja wykonawców. Nowe ramy weryfikacji w zamówieniach publicznych w 2026 r.

Od 12 lipca 2026 r. zacznie obowiązywać ustawa o certyfikacji wykonawców zamówień publicznych. Nowe regulacje wprowadzają systemową zmianę w zakresie...

KBZ LEGAL ALERT | Prawo pracy 2026

Szanowni Państwo, uprzejmie informujemy o najnowszych zmianach w obszarze prawa pracy, które weszły w życie na początku 2026 roku i mają istotne znaczenie...